فایل robots.txt چیست و نحوه ایجاد آن

بهینه سازی موتور جستجو (SEO) شامل تغییرات بزرگ و کوچک وب سایت است. فایل robots.txt ممکن است یک عنصر فنی و جزئی سئو به نظر برسد، اما میتواند بر روی دید و رتبهبندی سایت شما تأثیر زیادی بگذارد. با خواندن این مطلب می توانید اهمیت این فایل را برای عملکرد و ساختار سایت خود ببینید.

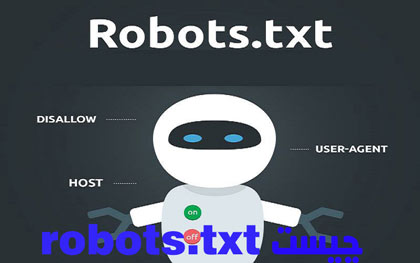

فایل robots.txt چیست؟

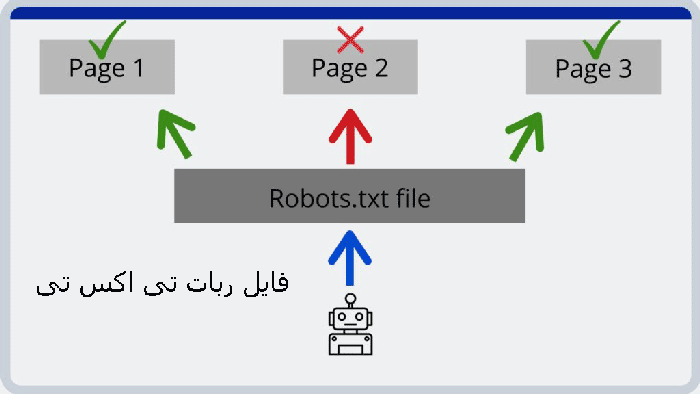

یک فایل متنی است که در دایرکتوری اصلی وب سایت در سرور قرار دارد. این شامل دستورالعمل هایی است که خزنده های موتور جستجو می توانند بر روی آنها به فهرستها یا پرونده هایی دسترسی داشته باشند. برای کنترل رفتار خزیدن استفاده می شود.

اگر خزنده ها اجازه دسترسی به همه صفحات ، تصاویر یا PDF را دارند یا اگر قبلاً صفحات جداگانه با برچسب noindex را حذف نکرده اید ، لزوماً به چنین پرونده ای نیاز ندارید. در زیر می توانید نحوه کار این را در وردپرس جستجو کنید. خزنده ها اساساً تصور می کنند که مجاز به دیدن همه چیز در یک وب سایت هستند. اما اینکه چرا اغلب پیشنهاد دادن همه چیز به خزنده ها منطقی نیست ، نکته بعدی را ببینید.

چگونه کار می کند؟

قبل از اینکه موتور جستجوی وب سایت شما را خز کند ، به فایل شما برای راهنمایی در مورد صفحات اجازه خزیدن و فهرست بندی در نتایج موتور جستجو نگاه می کند.

اگر می خواهید موتورهای جستجو ایندکس نشوند ، پرونده های ربات تی اکس تی مفید هستند:

- صفحات تکراری یا شکسته شده را در وب سایت خود قرار دهید

- صفحات نتایج جستجو داخلی(لینک های داخلی سایت)

- مناطق خاصی از وب سایت یا دامنه کامل شما

- فایلهای خاصی در وب سایت شما مانند تصاویر و PDF

- صفحات ورود

- اجرای وب سایت برای توسعه دهندگان

- نقشه سایت XML شما

استفاده از پرونده های robots.txt به شما امکان می دهد صفحاتی را حذف کنید که هیچ فایده ای ندارند ، بنابراین موتورهای جستجو به جای آن روی خزیدن مهمترین صفحات تمرکز می کنند.

چرا Google دیگر از برچسب <noindex> در robots.txt پشتیبانی نمی کند؟

گنجاندن noindex در robots.txt هرگز روش درستی نبوده است ، به ویژه هنگامی که صفحه حاوی برچسب در کد HTML باشد. بنابراین ، هنوز هم می تواند در نتایج جستجو ظاهر شود. این اتفاق می افتد زمانی که ، به عنوان مثال ، پیوندهایی به صفحات تنظیم شده روی <noindex> وجود دارد.

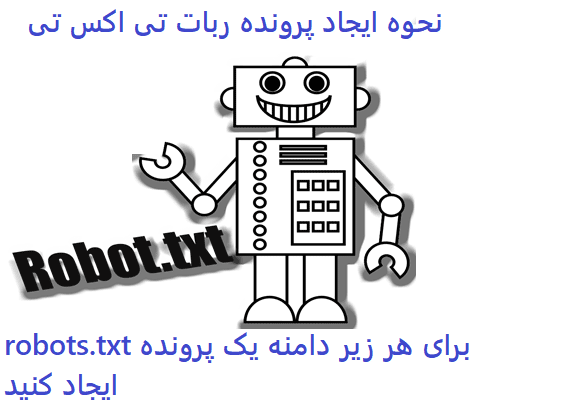

نحوه ایجاد پرونده ربات تی اکس تی

اگر در حال حاضر این فایل ندارید ، توصیه می شود در اسرع وقت آنرا ایجاد کنید. برای انجام این کار ، شما باید:

- یک فایل متنی جدید ایجاد کنید و آن را “robots.txt” بنامید – از ویرایشگر متنی مانند برنامه Notepad در رایانه های شخصی ویندوز یا TextEdit برای Mac ها استفاده کنید و سپس یک پرونده با متن “Save As” را ذخیره کنید ، و اطمینان حاصل کنید که پسوند پرونده “.txt” نامگذاری شده است

- آن را در فهرست اصلی وب سایت خود بارگذاری کنید – این معمولاً یک پوشه سطح ریشه به نام “htdocs” یا “www” است که باعث می شود مستقیماً پس از نام دامنه شما ظاهر شود

- برای هر زیر دامنه یک پرونده ایجاد کنید – فقط در صورت استفاده از هر دامنه فرعی

- تست – با وارد کردن yourdomain.com/robots.txt در نوار آدرس مرورگر ، پرونده robots.txt را بررسی کنید

چرا باید به ربات تی اکس تی اهمیت دهید؟

از دیدگاه SEO نقش اساسی دارد. این به موتورهای جستجو می گوید که چگونه می توانند به بهترین شکل وب سایت شما را جستجو کنند.

با استفاده از فایل می توانید از دسترسی موتورهای جستجو به قسمت های خاصی از وب سایت خود جلوگیری کنید ، از محتوای تکراری جلوگیری کرده و به موتورهای جستجو نکات مفیدی درباره چگونگی کارآیی تر وب سایت شما ارائه دهید.

در هنگام ایجاد تغییر در robots.txt مراقب باشید : این پرونده امکان ایجاد قسمتهای زیادی از وب سایت شما را برای موتورهای جستجو غیرقابل دسترسی می کند.

برخی از دلایل داشتن پرونده /robots.txt در وب سایت ما می تواند شامل موارد زیر باشد:

- ما محتوا داریم که می خواهیم از موتورهای جستجو مسدود شود.

- پیوندها یا تبلیغات پولی وجود دارد که برای ربات های مختلف وب نیاز به دستورالعمل های ویژه دارند.

- ما می خواهیم دسترسی به سایت خود را از روبات های معتبر محدود کنیم.

- ما در حال ایجاد یک سایت زنده هستیم ، اما شما نمی خواهید موتورهای جستجو هنوز آن را ایندکس کنند.

- برخی از موارد فوق صحیح است ، اما ما دسترسی کاملی به وب سرور و نحوه پیکربندی آن نداریم.

با این وجود ، روش های دیگر می توانند دلایل فوق را کنترل کنند ، اما پرونده /robots.txt یک مکان مرکزی درست و مستقیم برای مراقبت از آنها است. اگر ما یک فایل /robots.txt در وب سایت خود نداریم ، روبات های موتور جستجو دسترسی کامل به سایت ما دارند.

چه چیزی را در پرونده robots.txt خود قرار دهید

بیایید مثالهای مختلفی از چگونگی استفاده از فایل robots.txt را مرور کنیم. توجه داشته باشید که می توانید با انجام یک خط با هشتگ ( # ) نظرات خود را به پرونده اضافه کنید .

همه موارد زیر در ربات txt کنار بذاریم

واضح است ، شما ممکن است بخواهید از ترکیبی از این روش ها برای مسدود کردن مناطق مختلف وب سایت خود استفاده کنید. موارد اساسی که باید به خاطر بسپارید:

- اگر زیر فهرست را مجاز نمی کنید ، هر پرونده ، زیر فهرست یا صفحه وب در آن الگوی URL مجاز نخواهد بود

- نماد ستاره ( * ) جایگزین هر شخصیت یا تعدادی از شخصیت ها می شود

- نماد دلار ( $ ) انتهای URL را نشان می دهد ، بدون استفاده از این مورد برای مسدود کردن پسوند فایل ها ، ممکن است تعداد زیادی URL را به طور تصادفی مسدود کنید

- آدرس های اینترنتی حساس به مورد هستند ، بنابراین ممکن است مجبور شوید نسخه های کلاه و غیر کلاه را برای گرفتن همه درج کنید

- این می تواند موتورهای جستجو را چند روز تا چند هفته به طول انجامد تا متوجه نشانی اینترنتی مجاز نشود و آن را از فهرست آنها حذف کند

- تنظیمات ” کاربر-عامل ” به شما امکان می دهد تا برخی از نقاط خزنده را مسدود کنید یا در صورت لزوم با آنها متفاوت رفتار کنید ، می توانید در اینجا لیست کاملی از ربات های عامل کاربر را پیدا کنید تا جایگزین نماد ستاره گیر (*) شوید.

- پرونده robots.txt خود را با استفاده از تستر گوگل ربات تی اکس تی تست کنید

نقشه سایت

ذکر پیوند به نقشه سایت شما در پرونده روبات ها یک اختیاری است اما یک عمل خوب برای دنبال کردن.

روبات txt اولین پرونده ای است که خزنده جستجو پس از فرود در وب سایت شما به دنبال آن است.

در دسترس بودن آدرس سایت نقشه سایت کار خزنده را آسان می کند زیرا می تواند از نقشه سایت برای ایجاد درک وب سایت خود استفاده کند.

فقط FYI ، Google از طریق کنسول جستجو به نقشه سایت شما دسترسی پیدا می کند ، اما این می تواند یک عمل خوب برای سایر نمایندگان کاربر باشد.

پرونده ربات تی اکس تی در کجا قرار دارد؟

داشتن پرونده robots.txt در سرور شما کافی نیست. باید در پوشه ریشه وب سایت خود اقامت داشته باشد. قرار دادن آن در یک پوشه ، آن را بی فایده می کند.

اگر با خطای سرور 404 روبرو شدید یا URL برای دسترسی به پرونده روبات های شما با آنچه در بالا گفته شد متفاوت است ، در نظر بگیرید که پرونده ربات های شما به درستی تنظیم نشده است.

فایل robots.txt به چه صورت است؟

نمونه ای از آنچه ممکن است یک فایل ساده robots.txt برای وب سایت وردپرس به نظر برسد:

User-agent: *

Disallow: /wp-admin/بیایید آناتومی فایل را بر اساس مثال بالا توضیح دهیم:

- User-agent:

user-agentنشانگر راهنمایی که برای موتورهای جستجو در نظر گرفته شده است. *: این نشان می دهد که دستورالعمل ها برای همه موتورهای جستجو طراحی شده اند.Disallow: این یک دستورالعمل است که نشان می دهد چه محتوایی برای آن قابل دسترسی نیستuser-agent./wp-admin/: این همانpathچیزی است که برایuser-agent.

دستورالعمل را در ربات تی اکس تی اجازه ندهید

شما می توانید به موتورهای جستجو بگویید که به پرونده ها ، صفحات یا بخش های خاصی از وب سایت خود دسترسی ندارند. این کار با استفاده از Disallowبخشنامه انجام می شود . این Disallowبخشنامه دنبال می شود pathکه نباید به آن دسترسی پیدا کرد. در صورت عدم pathتعریف ، این بخشنامه نادیده گرفته می شود.

مثال

User-agent: *

Disallow: /wp-admin/در این مثال به کلیه موتورهای جستجو گفته شده است که به فهرست دسترسی نداشته باشند /wp-admin/.

نمونه ای از بخشنامه های متناقض

User-agent: *

Allow: /directory

Disallow: *.htmlموتورهای جستجو نمی دانند با URL چه کار کنند http://www.domain.com/directory.html. برای آنها مشخص نیست که آیا اجازه دسترسی دارند. وقتی دستورالعمل ها برای گوگل روشن نیستند ، با کمترین محدودیت دستورالعمل روبرو می شوند ، که در این حالت به معنای دسترسی واقعی آنها است

مطلب زیر بخوانید

سئو محلی چیست یک راهنمای ساده برای SEO محلی

نتیجه

ما اهمیت /robots.txt را در وب سایت خود ، نحو آنها و آنچه می توانیم با آن در مزایای وب سایت خود انجام دهیم ، دیدیم. ما همچنین شاهد استفاده از متا تگ ربات ها و محدودیت های آن بودیم.

با این حال ، اگر از آن استفاده کنیم ، باید اطمینان حاصل کنیم که از آن به درستی استفاده می شود. یک فایل صحیح می تواند روبات های وب را از ایندکس کردن صفحات وب سایت ما مسدود کند ، یا با انتقادی جدی تر ، باید اطمینان حاصل کنیم که صفحاتی را که موتورهای جستجو برای رتبه بندی آنها مسدود می کنند مسدود نمی کنیم.

مطالب مشابه

با تشکر از سایت شما

مشکلاتم بر طرف شد